DataOps для прогнозирования спроса и управления запасами

- Backend

- DevOps

- Apache Airflow

- DAG

- GitSync

- Apache Spark

- Apache Kafka

- Kubernetes

- GitLab

- CI/CD

У вас есть задача? Давайте обсудим!

О клиенте

Российский продуктовый ритейлер управляет более чем 70 гипермаркетами и 200 дискаунтерами. Веб-сервис и мобильное приложение предлагают подборку из 30 000 товаров, 90‑минутную доставку, бонусную систему и омниканальные опции в ключевых регионах. Компания ежегодно внедряет новые маркетинговые активности, улучшает мерчандайзинг и расширяет СТМ‑ассортимент. По итогам 2024 года LfL‑продажи увеличились на 4,3%, средний чек — на 6%.

О проекте

С помощью системы ритейлер анализирует исторические данные о покупках, сезонные тренды, поведенческие паттерны в праздничные и выходные дни, а также различия по регионам России. Программа предсказывает потребность в товарах на уровне отдельных категорий и SKU, формирует рекомендации по объемам поставок и срокам пополнения, а также инициирует автоматические заявки на поставку. Чтобы повысить точность прогнозов, было решено внедрить DataOps.

Описание задачи

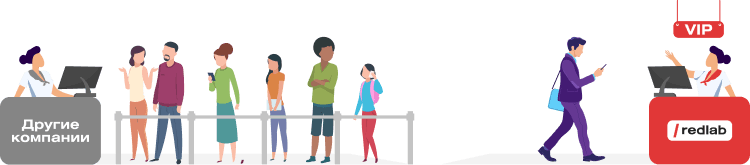

До сотрудничества с RedLab заказчик часто получал неполную и несвоевременную информацию о товарных остатках и изменениях спроса. Точность планирования страдала, возникали излишки или нехватка товаров в магазинах. Требовалось модернизировать систему принятия решений, а именно:

- Оптимизировать обмен сведениями между системой прогнозирования, складами, ERP и точками продаж.

- Автоматизировать загрузку, валидацию и актуализацию информации о товарообороте и остатках.

- Внедрить DataOps-практики для быстрого выявления тенденций и закономерностей в больших массивах данных.

Реализация

В процессе актуализации системы, инженеры RedLab выполнили следующие работы:

- Развернули ИТ-инфраструктуру в Kubernetes, что обеспечило отказоустойчивость и гибкое масштабирование компонентов.

- Внедрили CI/CD-процессы для быстрого вывода изменений в продуктив и автоматического тестирования пайплайнов.

- Выполнили оркестрацию пайплайнов обработки данных с помощью Apache Airflow и DAG, что позволило стабилизировать расписание задач и обеспечить контроль на каждом этапе прогноза.

- Подключили Apache Spark для обработки больших объемов исторических сведений о продажах и остатках. Это ускорило расчеты и помогло масштабировать систему под высокие нагрузки.

- Реализовали обмен событиями в реальном времени через Apache Kafka, чтобы учитывать оперативные данные из кассовых и складских систем при пересчете прогнозов.

- Настроили автоматическое тестирование пайплайнов обработки данных и контроль бизнес-логики, например, проверки SLA, допустимых значений, соответствия правилам агрегирования.

- Обеспечили сквозную прослеживаемость данных — от извлечения до формирования прогнозных рекомендаций, с возможностью аудита изменений, логирования этапов обработки и восстановления на заданных этапах пайплайна.

Результат

Переходите по ссылке, чтобы узнать об аутсорсинге ИТ-специалистов больше.