Внедрение ML-решений в банковский сервис

- Backend

- DevOps

- Pytorch

- Transformers

- Peft

- CatBoost

- PySpark

- Jira

- Confluence

Индустрия

Финтех

У вас есть задача? Давайте обсудим!

О клиенте

Российский банк из топ-5, услугами которого пользуются 20+ млн частных и 1+ млн корпоративных клиентов. Компания дает возможность разместить денежные средства в форме депозитов, оформить дебетовые и кредитные карты, взять потребительские и целевые займы и др. Рыночная капитализация компании по состоянию на август 2024 года составляет более 1 трлн рублей. В рамках стратегии трансформации бизнес растит долю небанковских продуктов — развивает платформу для поиска и покупки жилья, ПО для визуализации данных, сервис объявлений и пр.

О проекте

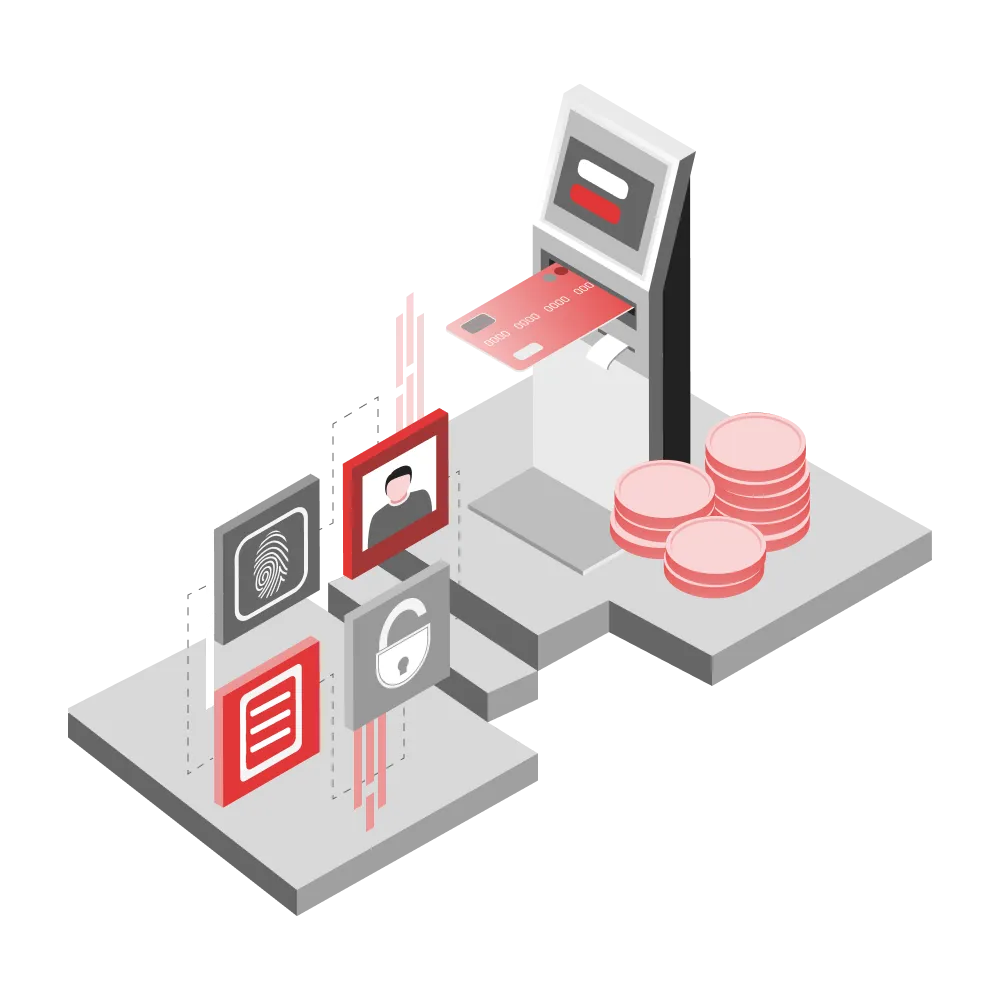

С помощью программы банк получает данные о клиентах из государственных информационных систем Российской Федерации и предоставляет пользователям услуги без бумажных документов. Потребителям не нужно вводить личные сведения вручную, чтобы заказать справку, получить кредит или оформить страховые выплаты. ИТ-продукт находится в постоянном развитии: происходит апгрейд ML-решений и оптимизация архитектуры ПО. Чтобы повысить точность и полноту информации о населении, бизнес нуждался в разработке новых моделей машинного обучения.

Описание задачи

До подключения команды RedLab заказчик часто получал неполные или устаревшие данные о своих клиентах. Это замедляло скорость предоставления финансовых услуг и затрудняло персонализацию предложений. Требовалось актуализировать существующий ИТ-продукт, а именно:

- Улучшить обмен данными между сервисом и интегрированным порталом государственных услуг РФ.

- Автоматизировать пополнение клиентского профиля сведениями из федеральных и региональных информационных ресурсов.

- Применить наиболее подходящие технологии ML для быстрого выявления тенденций и закономерностей в больших массивах данных.

Реализация

В процессе модернизации программы ML- и DevOps-инженеры RedLab выполнили следующие шаги:

- Построили интерпретируемые признаки из текстовых источников, которые позволили лучше понимать и использовать информацию для предсказаний и анализа.

- Использовали метод Data Mining на больших объемах данных для классификации будущих событий и прогнозирования еще неизвестных результатов.

- Составили техническую документацию — это облегчило сопровождение, модернизацию и интеграцию ML-моделей в дальнейшем.

- Обучили модели классификации текста (BERT, GPT), что повысило качество обработки текстовых данных.

- Выполнили валидацию обученных моделей. Теперь алгоритмы работают корректно и устойчиво на реальных данных, минимизируя риски ошибок и потерь сведений.

- Оптимизировали ансамбли нейросетевых моделей — повысилась общая производительность и устойчивость программы.

- Внедрили модели в промышленную среду, чтобы клиент получил уже готовые к использованию решения.

- Настроили Fine-Tuning больших языковых моделей. В итоге удалось повысить точность и адаптивность алгоритмов к конкретным задачам и доменам.

Результат